Pourquoi les utiliser ?

La fiabilité et l’espérance de vie d’un composant électronique sont directement liés à son régime thermique. Les pannes sont souvent dues à une température excessive et aux variations de température dans celui-ci (stress et fatigue thermique). Pour avoir une petite comparaison, on va prendre une ampoule de 100 W et un processeur dissipant 100 W également pour regarder la différence au niveau thermique. L’ampoule a une surface d’environ 100 cm2 ce qui donne un flux thermique sur sa paroi en verre de 1 W/cm2, ce qui est faible, on n’aurait absolument aucun mal à la refroidir si on avait à le faire. Par contre, un processeur avec un die de 1 cm2 aura un flux thermique de 100 W/cm2 ce qui est bien plus élevé et bien plus compliqué à refroidir en tenant compte des impératifs de fonctionnement. De plus, avec le temps, les choses ne font qu’empirer car la densité de flux de chaleur a tendance à augmenter malgré une finesse de gravure et une consommation qui diminuent, car on en profite évidemment pour en mettre 30 % de plus dedans.

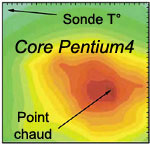

L’augmentation de ces densités de flux de chaleur s’accompagne en même temps d’une accentuation de la présence de points chauds. Quand on parle de température du core, il faut savoir que celle-ci n’est pas du tout homogène à cause de ces points chauds justement. Ce sont eux, en général, qui empêchent de monter plus haut en fréquence par exemple. En effet, si la température de la sonde interne indique 55 °C, celle des points chauds peut être 10 °C supérieure localement et entraîner une instabilité. Ils existent, car la répartition du cache et des unités de calcul dans le processeur provoque une accumulation de puissance en certains endroits. La densité de puissance aux points chauds est plus élevée qu’ailleurs (200 à 400 W/cm2). Pour prendre un exemple, Cooligy annonce que leur nouvel échangeur à microcanaux permettrait théoriquement de faire face à des pics de 1000 W/cm2. Ca ne veut pas du tout dire qu’on a 1000 W à absorber puisque c’est en rapport à une surface donnée très petite.

Ci-contre, une photo d’un processeur dont le core est recouvert de liquide thermographique noir, qui a la propriété de changer de couleur suivant la température locale. C’est un liquide souvent utilisé dans la recherche pour voir la répartition de température sur une surface puisqu’il existe une large gamme de températures couvertes. On aperçoit nettement que le core possède 2 points bleus plus chauds que tout le reste. Ce sont 2 endroits sous lesquels se trouve probablement une unité de calcul très sollicitée qui chauffe donc plus. L’une des facilités offertes par les microcanaux et par la connaissance de l’emplacement des points chauds est la possibilité de créer des zones distinctes dans l’échangeur. On pourra mettre des ailettes plus nombreuses et fines aux endroits chauds et moins nombreuses partout ailleurs. On optimise ainsi le transfert thermique en fonction d’un composant en limitant si possible les pertes de charges inutiles.

Ci-contre, une photo d’un processeur dont le core est recouvert de liquide thermographique noir, qui a la propriété de changer de couleur suivant la température locale. C’est un liquide souvent utilisé dans la recherche pour voir la répartition de température sur une surface puisqu’il existe une large gamme de températures couvertes. On aperçoit nettement que le core possède 2 points bleus plus chauds que tout le reste. Ce sont 2 endroits sous lesquels se trouve probablement une unité de calcul très sollicitée qui chauffe donc plus. L’une des facilités offertes par les microcanaux et par la connaissance de l’emplacement des points chauds est la possibilité de créer des zones distinctes dans l’échangeur. On pourra mettre des ailettes plus nombreuses et fines aux endroits chauds et moins nombreuses partout ailleurs. On optimise ainsi le transfert thermique en fonction d’un composant en limitant si possible les pertes de charges inutiles.

Le positionnement de la sonde interne de température est donc relatif et ne reflète pas vraiment la température la plus haute. Chez Intel par exemple, la sonde est placée dans un coin « froid » du core et un point chaud se trouve complètement à l’opposé. La cartographie thermique est obtenue par simulation numérique à partir de la connaissance des unités qui composent le core. En effet, on ne peut pas la connaître directement par thermographie car un processeur actuel utilisé sans radiateur signifie sa destruction en quelques instants, souvenez vous des vidéos montrant un core AMD qui brûle lorsque son radiateur est enlevé… Le fait de graver directement les canaux sur le core permettrait de limiter l’influence de ces points chauds sur la stabilité. On serait alors au plus près de la source de chaleur en ayant les moyens de transférer la puissance efficacement. Cela ne signifie pas qu’il faille faire un waterblock quelconque avec une base très fine pour se rapprocher de ces points chauds ! Si l’écoulement n’est pas adapté (impact de jet ou microcanaux) pour absorber la puissance sans devoir l’étaler, l’échangeur ne vaudra pas grand-chose en performances.

Le positionnement de la sonde interne de température est donc relatif et ne reflète pas vraiment la température la plus haute. Chez Intel par exemple, la sonde est placée dans un coin « froid » du core et un point chaud se trouve complètement à l’opposé. La cartographie thermique est obtenue par simulation numérique à partir de la connaissance des unités qui composent le core. En effet, on ne peut pas la connaître directement par thermographie car un processeur actuel utilisé sans radiateur signifie sa destruction en quelques instants, souvenez vous des vidéos montrant un core AMD qui brûle lorsque son radiateur est enlevé… Le fait de graver directement les canaux sur le core permettrait de limiter l’influence de ces points chauds sur la stabilité. On serait alors au plus près de la source de chaleur en ayant les moyens de transférer la puissance efficacement. Cela ne signifie pas qu’il faille faire un waterblock quelconque avec une base très fine pour se rapprocher de ces points chauds ! Si l’écoulement n’est pas adapté (impact de jet ou microcanaux) pour absorber la puissance sans devoir l’étaler, l’échangeur ne vaudra pas grand-chose en performances.

Pour faire face à ce dégagement de puissance, il faut avoir un échange le plus efficace possible qui puisse retarder au maximum l’influence des points chauds. Il faut leur offrir une surface de contact, la plus froide possible, sur laquelle ils vont pouvoir décharger leur puissance à une température raisonnable. Cette température de contact va être imposée par la façon dont le transfert entre le fluide et les ailettes va se faire. On sait qu’un transfert thermique convectif entre un fluide et un solide s’exprime de la manière suivante :

Q = h x S x (T°paroi – T°fluide)

- Q = puissance à dissiper en W

- h = coefficient de transfert convectif en W/m2.K

- S = surface d’échange en m2

- T°paroi et T°fluide = températures de la paroi de l’échangeur et température moyenne du fluide

Pour améliorer les performances de l’échangeur et réduire l’écart de température entre la paroi et le fluide notamment, on peut donc influencer 2 facteurs :

- soit augmenter h en augmentant le débit pour rendre l’écoulement plus turbulent, en impactant plus vite, en mettant des perturbateurs…

- soit augmenter la surface mouillée S au contact du fluide

En général, les systèmes classiques jouent sur un seul des facteurs, car il n’est pas aisé de favoriser les 2 en même temps, du fait de leur influence mutuelle par interaction avec les pertes de charge par exemple. Tout le potentiel de refroidissement des microcanaux va se découvrir dans la suite de l’article puisqu’ils vont permettre d’augmenter les 2 facteurs en même temps sans trop s’embêter. Ils vont apporter les 2 choses fondamentales que l’on va développer, à savoir une très grande surface de contact entre le fluide et l’échangeur ainsi qu’un coefficient h élevé permettant de transférer efficacement la puissance au fluide.

Ici c’est très simplifié, mais il faut savoir que ces microstructures, contrairement au watercooling classique, posent des problèmes d’analyse pour les modéliser et les optimiser à cause de leurs tailles réduites. Même après 25 ans de recherche, il subsiste des lacunes dans la compréhension de certaines anomalies dans les expérimentations. Les caractéristiques des microécoulements, appelée microfluidique, dans les échelles micrométriques sont très légèrement différentes des écoulements macroscopiques (à notre échelle). Compte tenu des dimensions, certaines forces intermoléculaires entre la paroi et le fluide ne sont plus si négligeables que çà et vont interférer avec l’écoulement. Il est alors important de déterminer leurs impacts sur l’échangeur.